O Google está intensificando seus esforços em inteligência artificial (IA) multimodal, integrando texto, imagens, vídeo, áudio e outros dados não estruturados com IA generativa. Com previsões de crescimento anual de 35% no mercado de IA multimodal nos próximos anos, a empresa reposiciona o BigQuery como um lakehouse de dados capaz de coletar e analisar diversos tipos de informações. Empresas como Wendy's, UPS e Bell Canada já estão utilizando essas tecnologias para otimizar operações e extrair insights valiosos de dados antes inacessíveis.O Google está intensificando sua aposta na inteligência artificial multimodal, buscando uma posição de destaque em um mercado projetado para crescer mais de 35% anualmente nos próximos anos.

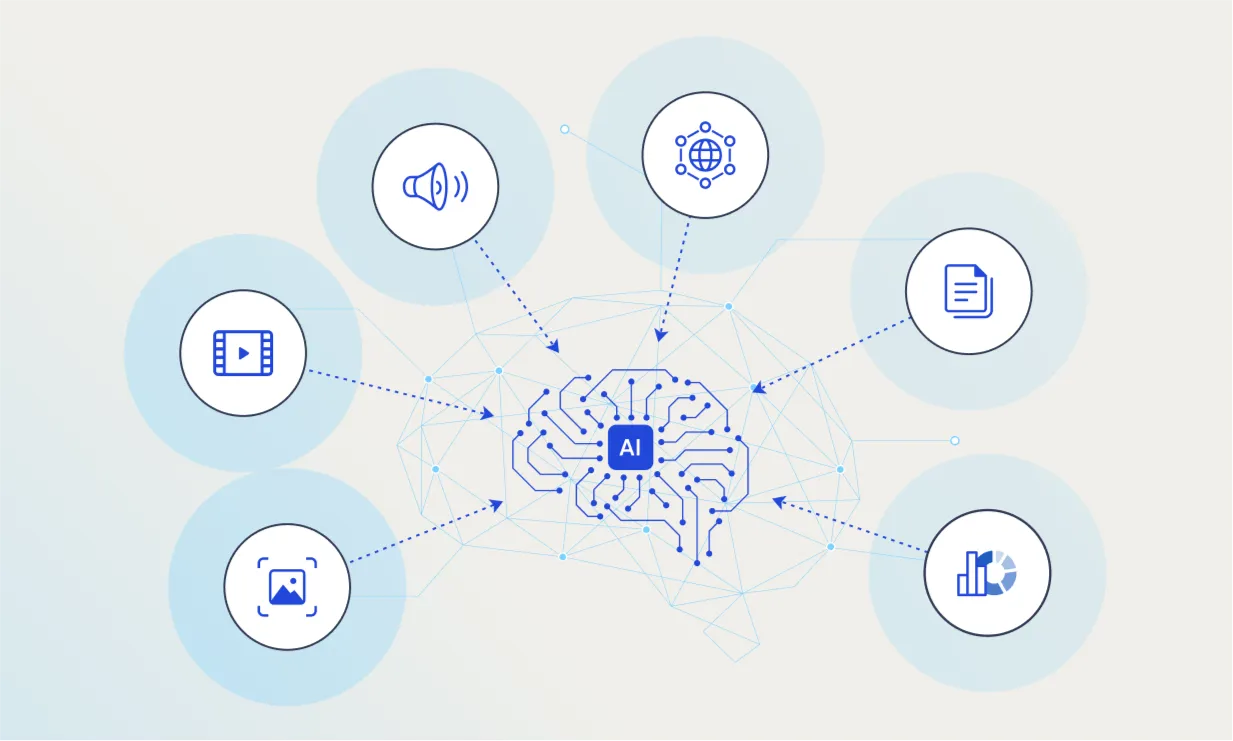

A IA multimodal combina texto, imagens, vídeo, áudio e outros dados não estruturados com processamento de IA generativa para gerar insights mais profundos.

No centro dessa estratégia está o BigQuery, o data warehouse do Google, que agora é reposicionado como um lakehouse de dados capaz de coletar e analisar uma variedade de tipos de dados.

Yasmeen Ahmad, executiva de estratégia e gestão de produtos em dados, analytics e IA no Google, afirma que o BigQuery “foi o lakehouse original antes mesmo do termo existir”.

Ela explica que a plataforma foi construída com um motor relacional para suportar todas as análises estruturadas que os clientes empresariais desejavam realizar.

O Google estima que 90% dos dados empresariais são não estruturados.

Ao combinar tecnologias como reconhecimento de imagem e voz com dados estruturados para treinamento de IA generativa, as organizações podem extrair insights de informações que antes eram inacessíveis.

Um exemplo é a rede de restaurantes Wendy’s, que está testando uma aplicação que combina BigQuery, Vision AI do Google e o modelo Gemini para analisar imagens de vídeo do tráfego em drive-thrus e identificar gargalos.

Os dados das imagens são combinados com informações de pessoal e agendamento para otimizar os níveis de equipe.

“Isso não é apenas análise de vídeo”, diz Ahmad.

“Os dados de vídeo ficam ao lado dos dados operacionais em uma plataforma unificada.”

A United Parcel Service (UPS) construiu um painel que utiliza dados de sensores montados em caminhões para otimizar rotas de entrega em tempo real, emitindo instruções específicas aos motoristas.

A Bell Canada está usando transcrições geradas por IA de chamadas para seu call center para treinar um assistente de coaching que fornece feedback aos agentes.

A IA multimodal pode permitir que varejistas recolham sentimentos dos clientes a partir de múltiplas fontes, como call centers, avaliações em mídias sociais e feedbacks em aplicativos móveis, alimentando um motor de IA generativa para descobrir novos segmentos para campanhas de marketing direcionadas.

“Essa combinação de dados multimodais e IA permite um nível de personalização e escalabilidade que antes era inatingível”, afirma Ahmad.

O modelo Gemini pode operar diretamente sobre a base de dados do BigQuery, eliminando a necessidade de transferências de dados e acelerando o desenvolvimento de aplicações.

Ahmad observa que muitas organizações estão agora implementando pilotos em poucas semanas.

A maioria das primeiras aplicações é para uso interno, já que as empresas são cautelosas ao introduzir a IA generativa para seus clientes.

Mas não faltam oportunidades dentro das operações internas, ressalta Ahmad.

“O caminho mais fácil é onde os clientes têm muitos dados coletados ao longo do tempo e não conseguiram fazer nada com eles”, explica ela.

“Com a base de dados multimodais do BigQuery e a integração com o Vision AI e o Gemini, é fácil fazer algo acontecer.”